La Inteligencia Artificial nos asusta y nos intriga. Casi cada semana, hay un nuevo susto de IA en las noticias como desarrolladores que cierran bots porque se volvieron demasiado inteligentes. La mayoría de estas noticias son el resultado de una investigación sobre IA malinterpretada por quienes están fuera del campo. Para conocer los fundamentos de la IA, no dudes en leer nuestro completo artículo sobre la IA.

El mayor temor sobre la IA es la singularidad (también llamada Inteligencia General Artificial), un sistema capaz de pensar a nivel humano. Según algunos expertos, la singularidad también implica la conciencia de la máquina. Independientemente de si es consciente o no, una máquina así podría mejorarse continuamente y llegar mucho más allá de nuestras capacidades. Incluso antes de que la inteligencia artificial fuera un tema de investigación en ciencias de la computación, escritores de ciencia ficción como Asimov estaban preocupados por esto e ideaban mecanismos (es decir, las Leyes de la Robótica de Asimov) para garantizar la benevolencia de las máquinas inteligentes.

Para los que vinieron a obtener respuestas rápidas:

- ¿La singularidad sucederá alguna vez? Según la mayoría de los expertos en IA, sí.

- ¿Cuándo ocurrirá la singularidad? Antes de que termine el siglo

- El 10% de los participantes piensa que es probable que la AGI ocurra en 2022

- Para 2040, la proporción es del 50%

- El 90% de los participantes piensa que es probable que la AGI ocurra en 2075.

- El 45% de los encuestados predice una fecha anterior a 2060

- El 34% de todos los participantes predijo una fecha posterior a 2060

- El 21% de los participantes predijo que la singularidad nunca ocurrirá.

- Louis Rosenberg, informático, empresario y escritor: 2030

- Patrick Winston, profesor del MIT y director del Laboratorio de Inteligencia Artificial del MIT desde 1972 hasta 1997: 2040

- Ray Kuzweil, informático, empresario y escritor de 5 best sellers nacionales, entre ellos The Singularity Is Near : 2045

- Jürgen Schmidhuber, cofundador en la empresa de IA NNAISENSE y director del laboratorio suizo de IA IDSIA: ~2050

- El pionero de la IA Herbert A. Simon en 1965: «las máquinas serán capaces, dentro de veinte años, de hacer cualquier trabajo que un hombre pueda hacer»

- La Quinta Generación de Ordenadores de Japón en 1980 tenía un plazo de diez años con objetivos como «mantener conversaciones casuales»

- La inteligencia humana es fija a menos que de alguna manera fusionemos nuestras capacidades cognitivas con las máquinas. La startup de encajes neuronales de Elon Musk pretende hacerlo, pero la investigación sobre los encajes neuronales está en las primeras fases.

- La inteligencia de las máquinas depende de los algoritmos, la potencia de procesamiento y la memoria. La potencia de procesamiento y la memoria han crecido a un ritmo exponencial. En cuanto a los algoritmos, hasta ahora hemos sido buenos suministrando a las máquinas los algoritmos necesarios para utilizar su potencia de procesamiento y su memoria de forma eficaz.

Las respuestas más matizadas están a continuación. Se han realizado varias encuestas e investigaciones a científicos de la IA en las que se preguntaba sobre cuándo se produciría este hecho.

Entérate de los resultados de las principales encuestas a investigadores de la IA en 2 minutos

Examinamos los resultados de 4 encuestas con 995 participantes en las que los investigadores estimaban cuándo se produciría la singularidad. En todos los casos, la mayoría de los participantes esperaba la singularidad de la IA antes de 2060.

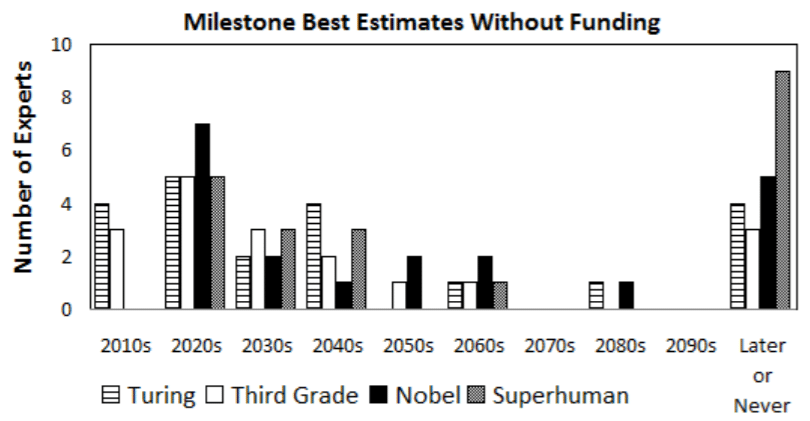

En 2009, se encuestó a 21 expertos en IA que participaron en la conferencia AGI-09. Los expertos creen que la AGI se producirá en torno al año 2050, y posiblemente antes. Puedes ver más arriba sus estimaciones respecto a logros específicos de la IA: superar el test de Turing, pasar el tercer grado, lograr avances científicos dignos de un Nobel y alcanzar una inteligencia sobrehumana.

En 2012/2013, Vincent C. Muller, presidente de la Asociación Europea de Sistemas Cognitivos, y Nick Bostrom, de la Universidad de Oxford, que publicó más de 200 artículos sobre superinteligencia e inteligencia general artificial (AGI), realizaron una encuesta entre investigadores de IA. 550 participantes respondieron a la pregunta: «¿Cuándo es probable que ocurra la AGI?». Las respuestas se distribuyen como

En mayo de 2017, se encuestó a 352 expertos en IA que publicaron en las conferencias NIPS e ICML de 2015. Basándose en los resultados de la encuesta, los expertos estiman que hay un 50% de posibilidades de que la AGI ocurra hasta 2060. Sin embargo, hay una importante diferencia de opinión basada en la geografía: Los encuestados asiáticos esperan la AGI dentro de 30 años, mientras que los norteamericanos la esperan dentro de 74 años. Algunas funciones laborales significativas que se espera que se automaticen hasta 2030 son: Representantes de centros de llamadas, conducción de camiones, ventas al por menor.

En 2019, 32 expertos en IA participaron en una encuesta sobre el tiempo de la AGI:

Los empresarios de la IA también hacen estimaciones sobre cuándo alcanzaremos la singularidad y son un poco más optimistas que los investigadores:

Tenga en cuenta que los investigadores de IA fueron demasiado optimistas antes

Los ejemplos incluyen:

Esta experiencia histórica contribuye a que la mayoría de los científicos actuales rehúyan predecir la AGI en plazos audaces como 10-20 años. Sin embargo, el hecho de que ahora sean más conservadores no significa que esta vez estén en lo cierto.

Entiende por qué alcanzar la AGI parece inevitable para la mayoría de los expertos

Pueden parecer predicciones descabelladas, pero parecen bastante razonables si se tienen en cuenta estos hechos:

Considerando que nuestra inteligencia es fija y la de las máquinas está creciendo, es sólo cuestión de tiempo que las máquinas nos superen, a menos que haya algún límite duro para su inteligencia. Todavía no hemos encontrado ese límite.

Esta es una buena analogía para entender el crecimiento exponencial. Aunque las máquinas pueden parecer tontas ahora mismo, pueden volverse muy inteligentes, muy pronto.

Si la computación clásica frena su crecimiento, la computación cuántica podría complementarla

La computación clásica nos ha llevado bastante lejos. Los algoritmos de IA en ordenadores clásicos pueden superar el rendimiento humano en tareas específicas como jugar al ajedrez o al Go. Por ejemplo, AlphaGo Zero venció a AlphaGo por 100-0. AlphaGo había vencido a los mejores jugadores del planeta. Sin embargo, nos estamos acercando a los límites de lo rápidos que pueden ser los ordenadores clásicos.

La ley de Moore, que se basa en la observación de que t el número de transistores en un circuito integrado denso se duplica aproximadamente cada dos años, implica que el coste de la computación se reduce a la mitad aproximadamente cada 2 años. Sin embargo, la mayoría de los expertos creen que la ley de Moore está llegando a su fin durante esta década. Aunque se están haciendo esfuerzos para seguir mejorando el rendimiento de las aplicaciones, será un reto mantener las mismas tasas de crecimiento.

La computación cuántica, que todavía es una tecnología emergente, puede contribuir a reducir los costes de computación después de que la ley de Moore llegue a su fin. La computación cuántica se basa en la evaluación de diferentes estados al mismo tiempo, mientras que los ordenadores clásicos pueden calcular un estado a la vez. La naturaleza única de la computación cuántica puede utilizarse para entrenar eficazmente las redes neuronales, actualmente la arquitectura de IA más popular en las aplicaciones comerciales. Los algoritmos de IA que se ejecutan en ordenadores cuánticos estables tienen la oportunidad de desbloquear la singularidad.

Para obtener más información sobre los ordenadores cuánticos no dude en leer nuestros artículos sobre la computación cuántica.

Entender por qué algunos no creen que nunca llegaremos a la AGI

Hay 3 argumentos principales contra la importancia o la existencia de la AGI. Los examinamos junto con sus refutaciones comunes:

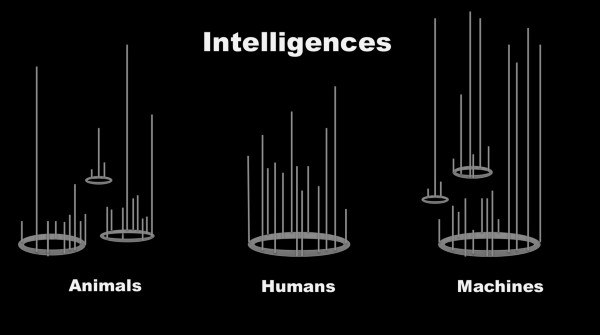

1- La inteligencia es multidimensional

Por lo tanto, la AGI será diferente, no superior a la inteligencia humana. Esto es cierto y la inteligencia humana también es diferente a la inteligencia animal. Algunos animales son capaces de hazañas mentales asombrosas, como las ardillas que recuerdan dónde escondieron cientos de nueces durante meses.

Sin embargo, estas diferencias no impiden que los humanos logren mucho más que otras especies en términos de muchas medidas típicas de éxito para una especie. Por ejemplo, el homo sapiens es la especie que más contribuye a la masa biológica del planeta entre los mamíferos.

2- La inteligencia no es la solución a todos los problemas

Por ejemplo, incluso la mejor máquina que analice los datos existentes probablemente no podrá encontrar la cura del cáncer. Tendrá que realizar experimentos y analizar los resultados para descubrir nuevos conocimientos en la mayoría de las áreas.

Esto es cierto con algunas salvedades. Una mayor inteligencia puede conducir a experimentos mejor diseñados y gestionados, permitiendo más descubrimientos por experimento. La historia de la productividad de la investigación probablemente debería demostrar esto, pero los datos son bastante ruidosos y hay rendimientos decrecientes en la investigación. Nos encontramos con problemas más difíciles como la física cuántica a medida que resolvemos problemas más simples como el movimiento newtoniano.

3- La AGI no es posible porque no es posible modelar el cerebro humano

Teóricamente es posible modelar cualquier máquina computacional, incluyendo el cerebro humano, con una máquina relativamente simple que pueda realizar cálculos básicos y tenga acceso a memoria y tiempo infinitos. Esta es la hipótesis de Church-Turing expuesta en 1950. Está universalmente aceptada. Sin embargo, como se ha dicho, requiere ciertas condiciones difíciles: tiempo y memoria infinitos.

La mayoría de los informáticos creen que se necesitará menos tiempo y memoria infinitos para modelar el cerebro humano. Sin embargo, no hay una forma matemáticamente sólida de demostrar esta creencia, ya que no entendemos el cerebro lo suficiente como para comprender exactamente su poder de computación. Tendremos que construir una máquina así¡

Y aún no lo hemos conseguido. Aunque el modelo de lenguaje GPT-3, lanzado en junio/2020, causó un gran entusiasmo por su fluidez, su falta de comprensión lógica hace que su resultado sea propenso a los errores. Para un ejemplo más dramático, este es un vídeo de lo que ocurre cuando las máquinas juegan al fútbol. Es un poco anticuado (de 2017) pero hace que incluso yo me sienta como una leyenda del fútbol en comparación:

Para saber más sobre la Inteligencia General Artificial

La conferencia de Ray Kurzweil:

Joshua Brett Tenenbaum, un profesor de Ciencia Cognitiva y Computación en el MIT, está explicando cómo podemos alcanzar la singularidad de la AGI:

Espero que esto aclare algunos de los puntos principales con respecto a la AGI. Para saber más sobre cómo la IA está cambiando el mundo, puedes consultar los artículos sobre IA, tecnologías de IA y aplicaciones de IA en marketing, ventas, atención al cliente, TI, datos o analítica. O puede seguir nuestra página de Linkedin donde compartimos cómo la IA está impactando en las empresas y en los individuos o nuestra cuenta de twitter.

Y si tiene un problema de negocio que no se aborda aquí:

Permítanos encontrar el proveedor adecuado para su negocio.

0 comentarios